个体在做决策时,虽然其效用(payoff)与现实世界的真实状态(state)有关,但往往无法观察到真实的状态。为了估计真实的状态,个体会考虑进行试验(experiment)以获取一些能够反应真实状态的信号(signal)。试验的好坏可以用其提供的信息量(或者更高的期望效用)来衡量。Blackwell 定理为试验之间的比较提供了建议一个简单的刻画。

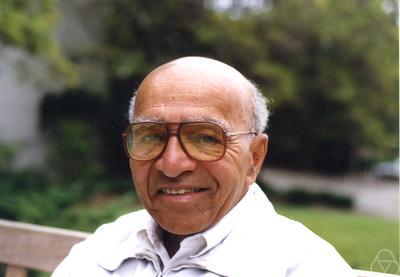

Blackwell 定理由 David Blackwell 在 1951 年建立。值得一提的是,David Blackwell 是 UC Berkeley 第一个终身轨的黑人教授。

假设现实世界的真实状态有 $$n$$ 种可能 $$\omega_1$$,$$\omega_2$$,$$\ldots$$,$$\omega_n$$,同时假设 $$\omega_i$$ 出现的概率是 $$p_i$$。记 $$p = (p_1, p_2, \ldots, p_n)$$。

假设试验 $$P$$ 是一个 $$n \times m$$ 维的行随机矩阵(即每行的行和等于 1),其中 $$P_{ij}$$ 表示当真实状态是 $$\omega_i$$ 时观察的信号是 $$s_j$$ 的概率。不同的试验对应的可能的信号集合会不一样,因此维数 $$m$$ 也可能不一样。

在观察到信号 $$s_j$$ 之后,个体将在有限个选择 $$A = \{ a_1, a_2, \ldots, a_l \}$$ 中进行选择。个体的效用函数依赖于自己的选择和真实的状态,可以用一个 $$l \times n$$ 维的矩阵 $$U$$ 表示:$$U_{ki}$$ 表示真实状态是 $$\omega_i$$ 时选择 $$a_k$$ 的效用。

在决策问题中,个体的(混合)策略 $$D$$ 是一个 $$m \times l$$ 维的行随机矩阵,其中 $$D_{jk}$$ 表示个体观察到信号 $$s_j$$ 时选择 $$a_k$$ 的概率。

当真实状态是 $$\omega_i$$ 时,采用试验 $$P$$ 和策略 $$D$$ 得到的效用是

$$! \sum_{j=1}^{m} P_{ij} \sum_{k=1}^{l} D_{jk} \cdot U_{ki} = (PDU)_{ii}$$

于是,$$diag(PDU) = \big( (PDU)_{11}, (PDU)_{22}, \ldots, (PDU)_{nn} \big)$$ 表示的是效用向量(payoff vector)。随着 $$D$$ 变化,该效用向量也会改变,记所有可能的效用向量为 $$B(P, U) = \{ diag(PDU) \mid D \text{ is a stochastic matrix} \}$$。

因为真实状态的先验概率(prior)是 $$p$$,所以采用试验 $$P$$ 和策略 $$D$$ 得到的期望效用是

$$!\sum_{i=1}^{n} p_i \sum_{j=1}^{m} P_{ij} \sum_{k=1}^{l} D_{jk} \cdot U_{ki} = Trace(PDU \hat{p})$$

这里的 $$\hat{p}$$ 是一个 $$n \times n$$ 的矩阵,$$(i,i)$$ 位置元素是 $$p_i$$,非对角元素都是零。

因此最大的期望效用为 $$F(P,U,p) = \max_{D} Trace(PDU \hat{p})$$。

定义:如果对于每个 $$U$$,$$B(Q,U) \subseteq B(P,U)$$,那么称试验 $$P$$ 比试验 $$Q$$ 拥有更多的信息量(more informative)。

Blackwell 定理:考虑两个试验 $$P$$($$n \times m$$ 维)和 $$Q$$($$n \times m'$$ 维),以下三条等价:

- 试验 $$P$$ 比试验 $$Q$$ 拥有更多的信息量,即对于每个 $$U$$,$$B(Q,U) \subseteq B(P,U)$$。

- 对于每个 $$U$$ 和 $$p$$,$$F(P,U,p) \ge F(Q,U,p)$$。

- 存在一个行随机矩阵 $$M$$(合适的维数)使得 $$P = QM$$。

“3 → 1” 和 “1 → 2” 是显然的。以下证明 “2 → 3”:

假定对于每个 $$m \times m'$$ 维的行随机矩阵 $$M$$,$$Q \ne PM$$。于是 $$Q \not\in E$$,其中 $$E = \{ PM \mid M \text{ is a stochastic matrix} \}$$。由于 $$E$$ 是 $$\mathbb{R}^{n \times m'}$$ 中的凸闭子集。基于超平面分离定理,存在一个 $$n \times m'$$ 维的矩阵 $$G$$,使得对于每个 $$m \times m'$$ 维行随机矩阵 $$M$$,我们有

$$!Trace(G^t Q) > Trace(G^t PM)$$

(这里需要指出的是 $$n \times m'$$ 维矩阵空间上的线性泛函都是 $$Trace(G^t \cdot)$$ 的形式)

令 $$U^t = \hat{p}^{-1} G$$。所以,

$$!Trace(PDU \hat{p}) = Trace(PDG^t) = Trace(G^t PD) < Trace(G^t Q) = Trace(QU \hat{p})$$

因此我们有

$$!\max_{D} Trace(PDU \hat{p}) < Trace(QU \hat{p}) \le \max_D Trace(QDU \hat{p})$$

矛盾!

简单来说,Blackwell 定理说明了,如果试验 $$P$$ 比试验 $$Q$$ 拥有的信息量更丰富,那么 $$Q = PM$$。这个矩阵 $$M$$ 描述的是通过“篡改”试验 $$P$$ 的结果来得到试验 $$Q$$ 结果的过程,并且这一篡改过程与真实的状态毫无关系。由于矩阵 $$M$$ 是一个行随机矩阵,所以通过试验 $$P$$ 得到的后验概率(posterior)是通过试验 $$Q$$ 得到的后验概率(posterior)的保留均值的伸展(mean-preserving spread),这一意味着前者承受的期望风险更小。

参考文献

- Moshe Leshno and Yishay Spector, An elementary proof of Blackwell's theorem, Mathematical Social Sciences 25 (1992), 95–98.

- Tilman Borgers, Notes on Blackwell's Comparison of Experiments, 2009.

感谢孙老师的分享。在武大进修一年,孙老师的课是我觉得收获最大的,学到了很多精彩而有用的知识。说实话,如果孙老师在网上搞你的课程直播,我绝对会订购您的栏目的,哈哈。祝孙老师今后在学术和生活上不断完成自己的目标,取得更多成绩。